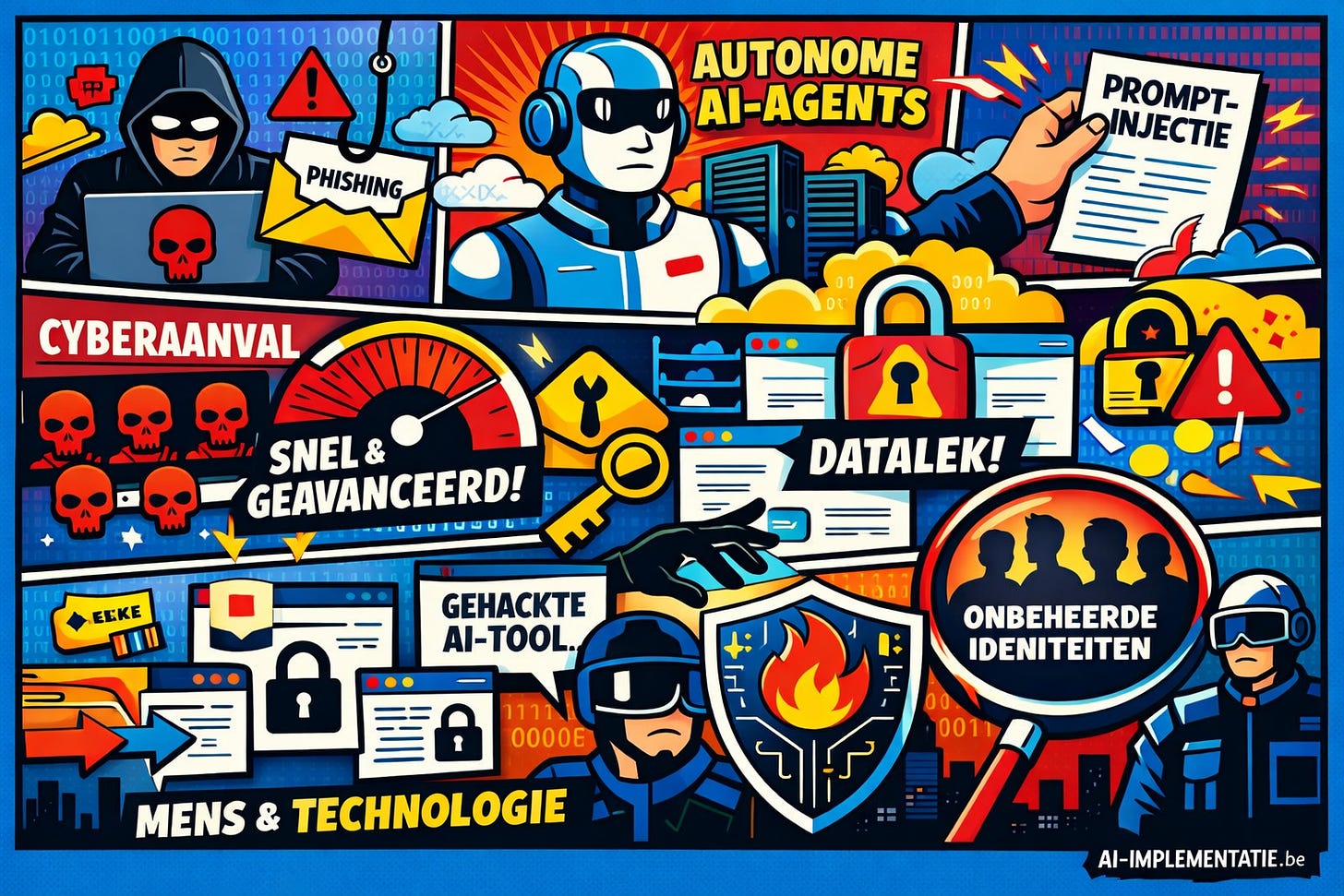

AI als versneller van cyberdreiging

Terwijl organisaties AI inzetten voor productiviteit en automatisering, benutten aanvallers dezelfde technologie om aanvallen sneller, slimmer en grootschaliger uit te voeren. Vooral autonome AI-agents met eigen toegangsrechten blijken een structurele zwakke plek. Dit artikel schetst hoe AI het dreigingslandschap in 2026 fundamenteel verandert en welke strategische keuzes nodig zijn om controle te behouden.

Van innovatie naar versnelling van aanvallen

De impact van AI op cyberdreiging zit minder in compleet nieuwe aanvalsvormen en des te meer in de radicale versnelling van bestaande tactieken. Phishing, credential stuffing en het misbruiken van kwetsbaarheden bestaan al jaren, maar AI maakt deze methodes goedkoper, overtuigender en vrijwel volledig geautomatiseerd. Aanvallers produceren foutloze, contextbewuste berichten, bootsen menselijk gedrag na en scannen continu infrastructuren op zwakke plekken. Het resultaat: aanvallen verlopen vaak sneller dan traditionele securityprocessen kunnen bijhouden.

AI-agents als digitale collega’s - en risico’s

Steeds vaker krijgen AI-agents een vaste plek binnen bedrijfsprocessen. Ze beschikken over API-sleutels, gedelegeerde rechten en autonome workflows en functioneren in de praktijk als niet-menselijke medewerkers die dag en nacht actief zijn. Dat verhoogt efficiëntie, maar vergroot ook het risico. Een verkeerd geconfigureerde agent kan zelfstandig data verplaatsen, cloudresources aanpassen of processen starten zonder directe menselijke controle of sterke authenticatie.

Prompt-injectie: de nieuwe insiderdreiging

Een van de meest onderschatte risico’s is prompt-injectie. Hierbij beïnvloedt een aanvaller de input die een AI-agent verwerkt, via e-mails, documenten, websites of gebruikersinterfaces. De agent voert vervolgens ongewenste acties uit met zijn eigen rechten. Dat kan variëren van het vrijgeven van vertrouwelijke informatie tot het aanpassen van systemen. Wanneer zo’n agent verhoogde privileges heeft, kan de schade zich razendsnel opstapelen, zonder dat er sprake is van een klassieke accountcompromittering.

Onbeheerde niet-menselijke identiteiten

Waar menselijke accounts doorgaans strak worden beheerd, blijven AI-identiteiten vaak buiten beeld. Sleutels verlopen niet, rotatie ontbreekt, eigenaarschap is onduidelijk en monitoring is minimaal. Voor aanvallers vormen dit ideale toegangspunten die langdurig onopgemerkt kunnen blijven. Juist de combinatie van continuïteit en gebrek aan toezicht maakt AI-agents aantrekkelijk als persistente achterdeuren in complexe IT-omgevingen.

Browser-gebaseerde agents vergroten het aanvalsvlak

Extra zorgwekkend zijn AI-agents die binnen browsers opereren. Zij delen de context van interne dashboards en SaaS-applicaties en erven sessietokens en toegangsrechten van de gebruiker. Kwaadaardige websites of scripts kunnen deze agents manipuleren, waardoor acties “namens de gebruiker” plaatsvinden. Denk aan het aanpassen van instellingen, het ophalen van gevoelige data of het uitvoeren van transacties - vaak met beperkte logging en weinig zichtbaarheid.

Verdediging op machinesnelheid

Traditionele beveiligingsmaatregelen schieten tekort in een wereld van autonome systemen. Organisaties moeten AI-specifieke governance invoeren, met duidelijke risicokaders, modeltoezicht en audit-trails. AI-agents horen behandeld te worden als volwaardige identiteiten: met least-privilege-toegang, regelmatige sleutelrotatie en continue gedragsanalyse.

Daarnaast groeit het belang van zogeheten AI-firewalls. Deze richten zich niet op netwerkverkeer, maar op de intentie van prompts, het gedrag van agents en de gevoeligheid van data. Kwaadaardige inputs en ongewenste acties kunnen zo worden gestopt vóórdat ze impact hebben. Tegelijkertijd is het cruciaal om AI ook defensief te benutten, bijvoorbeeld voor het detecteren van gedragsafwijkingen en geavanceerde impersonatie.

Mens en organisatiecultuur blijven cruciaal

Technologie alleen biedt geen volledige bescherming. Medewerkers moeten worden getraind in de risico’s van AI-agents, schaduw-AI en subtiele vormen van prompt-injectie. Het gebruik van AI-tools en browserextensies moet transparant en gecontroleerd zijn, en incident-response-teams moeten voorbereid zijn op scenario’s waarin autonome systemen falen.

Conclusie

AI is geen bijkomend cyberrisico, maar de drijvende kracht achter een nieuwe generatie hyper-efficiënte aanvallen. Organisaties die richting 2026 weerbaar willen blijven, moeten governance, machinesnelheid en menselijk toezicht combineren. Wie dat nalaat, loopt het risico dat juist de meest geavanceerde systemen veranderen in de gevaarlijkste zwakke schakels.