Edge AI verschuift het zwaartepunt van kunstmatige intelligentie naar lokaal rekenen

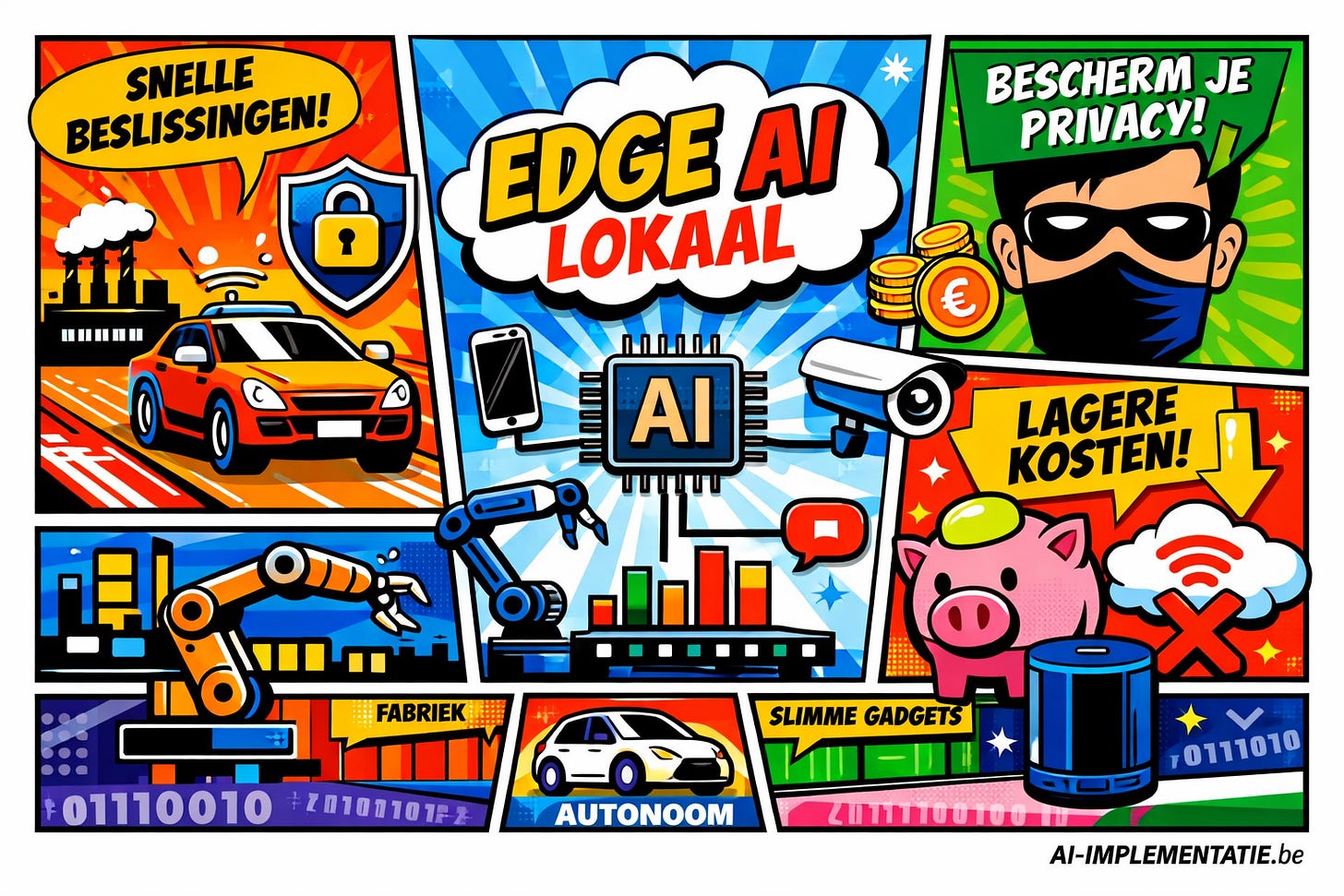

Kunstmatige intelligentie hoeft niet langer volledig in de cloud te draaien. Edge AI, waarbij AI-modellen lokaal op apparaten of aan de rand van het netwerk beslissingen nemen, ontwikkelt zich snel tot een volwaardig alternatief voor cloud-gebaseerde inferentie. Die verschuiving belooft snellere responstijden, lagere kosten en betere bescherming van gevoelige data. Tegelijkertijd dwingt Edge AI organisaties om anders te kijken naar modelbeheer, hardwarekeuzes en schaalbaarheid.

Van cloud naar rand van het netwerk

Jarenlang was de cloud het natuurlijke thuis van AI. Grote modellen, enorme datasets en krachtige GPU’s maakten centrale datacenters tot het kloppend hart van intelligente toepassingen. Maar naarmate AI vaker wordt ingezet in tijdkritische en privacygevoelige scenario’s, groeit de behoefte om beslissingen dichter bij de bron van data te nemen. Dat is precies waar Edge AI om draait: AI-inference uitvoeren op apparaten zelf, of op lokale servers die zich fysiek en logisch dicht bij de gebruiker bevinden.

In plaats van ruwe data continu heen en weer te sturen naar de cloud, worden gegevens lokaal geanalyseerd en omgezet in directe acties. Dat maakt Edge AI bijzonder geschikt voor omgevingen waar elke milliseconde telt of waar netwerkverbindingen niet altijd betrouwbaar zijn.

Waarom Edge AI terrein wint

De belangrijkste motor achter de opmars van Edge AI is latency. In toepassingen zoals autonome voertuigen, industriële robots of medische bewakingssystemen is vertraging simpelweg onacceptabel. Door inference lokaal uit te voeren, verdwijnt de wachttijd die ontstaat door netwerkverkeer richting de cloud.

Daarnaast speelt privacy een steeds grotere rol. Regelgeving en maatschappelijke verwachtingen dwingen organisaties om zorgvuldiger om te gaan met persoonsgegevens en bedrijfsgevoelige informatie. Lokale verwerking zorgt ervoor dat data het apparaat of het lokale netwerk niet hoeft te verlaten, wat het risico op datalekken aanzienlijk verkleint.

Ook financieel is Edge AI aantrekkelijk. Cloudinfrastructuur is uitstekend geschikt voor training en grootschalige analyse, maar inference op grote volumes kan kostbaar worden. Door een deel van die workload te verplaatsen naar edge-apparaten dalen zowel bandbreedte- als compute-kosten.

Technologische versnellers

Dat Edge AI nu volwassen begint te worden, is geen toeval. Meerdere technologische ontwikkelingen komen samen. Allereerst zijn AI-modellen zelf kleiner en efficiënter geworden. Waar eerdere modellen enorme hoeveelheden geheugen en rekenkracht vereisten, zijn moderne varianten geoptimaliseerd voor inferentie op beperkte hardware, zonder dat de nauwkeurigheid drastisch afneemt.

Daarnaast heeft hardware een inhaalslag gemaakt. Steeds meer chips bevatten gespecialiseerde AI-versnellers die specifiek zijn ontworpen voor energiezuinige berekeningen. Hierdoor kunnen edge-apparaten complexe taken uitvoeren zonder overmatig stroomverbruik of warmteontwikkeling.

Tot slot spelen lichtgewicht software-frameworks een cruciale rol. Deze maken het mogelijk om AI-modellen eenvoudig te deployen en draaien op uiteenlopende platforms, van industriële controllers tot consumentenelektronica, zonder zware cloudafhankelijkheid.

Praktische toepassingen vandaag

Edge AI is al lang geen theoretisch concept meer. In consumententoepassingen verwerken slimme camera’s en spraakassistenten audio en video lokaal om sneller en discreter te reageren. In de industrie analyseren sensoren continu productielijnen om afwijkingen direct te detecteren en stilstand te voorkomen. Ook in transport en mobiliteit neemt Edge AI een centrale rol in, doordat voertuigen autonoom beslissingen moeten kunnen nemen, zelfs zonder netwerkverbinding.

De keerzijde van decentralisatie

Toch brengt Edge AI nieuwe complexiteit met zich mee. Het beheren van grote aantallen gedistribueerde modellen is aanzienlijk lastiger dan het onderhouden van één centrale cloudomgeving. Updates, beveiligingspatches en modelverbeteringen moeten betrouwbaar en schaalbaar worden uitgerold.

Daarbij ontbreekt het nog aan uniforme standaarden. Hardware- en software-ecosystemen zijn gefragmenteerd, wat integratie en interoperabiliteit bemoeilijkt. En hoewel edge-hardware steeds krachtiger wordt, blijven de beschikbare middelen beperkt in vergelijking met cloudinfrastructuur, wat voortdurende optimalisatie vereist.

Een blijvende verschuiving

Edge AI luidt geen einde van de cloud in, maar markeert wel een duidelijke herverdeling van taken. Training en grootschalige analyse blijven vaak centraal plaatsvinden, terwijl inference steeds vaker lokaal gebeurt. Die hybride benadering combineert het beste van twee werelden: schaal en flexibiliteit in de cloud, snelheid en privacy aan de rand van het netwerk. Voor organisaties die AI strategisch willen inzetten, wordt Edge AI daarmee geen optie meer, maar een essentieel onderdeel van hun architectuur.